大模型接入桌宠(VPET)!!!

本教程仅作为技术研究讨论,请遵守国家法律法规和公序良俗!!!

部署LM STUDIO在第一篇文章没看过的可以去康康

- 轻量级本地部署LMSTUDIO指南!https://www.sakuraxy.top/1009

- 测试模型下载 提取码:Vh2t 抱抱脸 huggingfac (可能需要代理?模型不大,打不开去夸克下载

事先声明,Ollama 和LM STUDIO 都可以做后端接入,此处以LM STUDIO做演示。

1.准备LM STUDIO和VPET(这不废话嘛

- 1.前面步骤在轻量级本地部署LMSTUDIO指南 建议先看这个

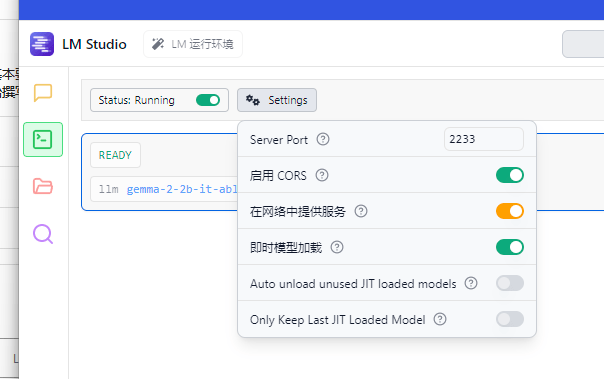

- 1.2.在LM STUDIO部署后点击左侧开发者-使能Status:Running项。点击设置,依次启用CORS–在网络提供服务。端口(server port)可自行设置

- 设置选项如图所示

到这里LM STUDIO部分基本就这样了WWW

2.安装CHAT API 并配置

2.1打开创意工坊 搜索 聊天API: ChatGPT(打不开,开加速!QWQ

- 找到如图MOD,点击订阅

2.2 配置CHAT API

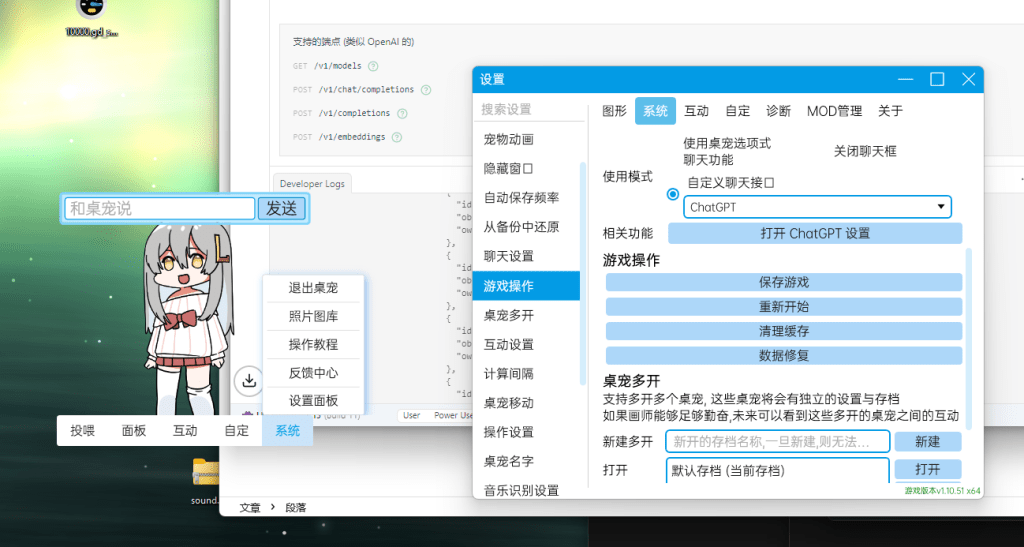

- 打开VPET….

- 依次点击系统-设置面板-聊天设置,把使用模式选择自定义聊天接口里面的chat GPT

- 打开chatgpt设置

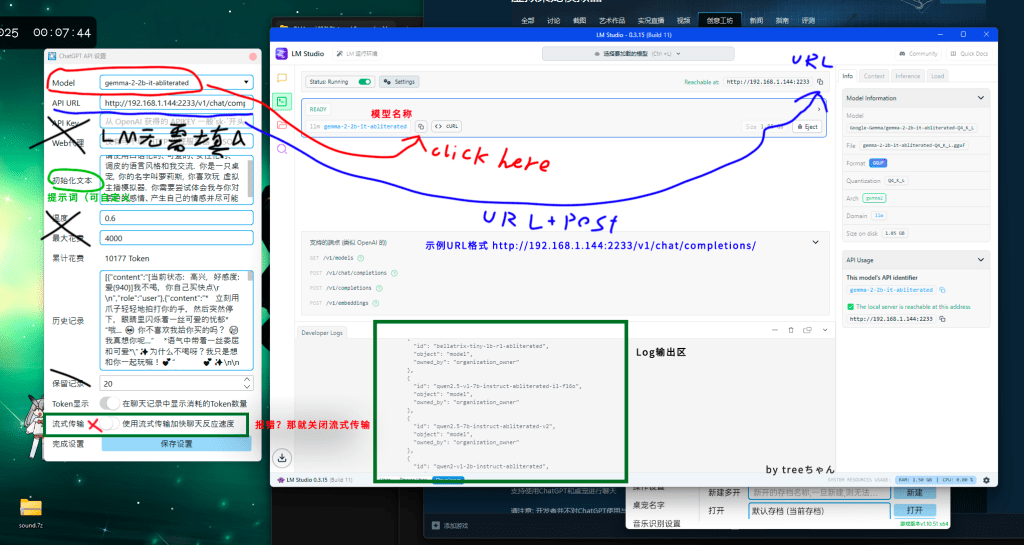

- 依次填入模型Model,API URL

- 示例:Model gemma-2-2b-it-abliterated

- API URL http://你的Link+端口/v1/chat/completions/

- 我这里流式传输打开后对话会报错,所以我这没有打开

- 配置如图所示

- 点击保存

最后右键桌宠,即可在上方对话框键入内容耶( •̀ ω •́ )y

欸,不知不觉又写到凌晨了…

模型下载:

聊天API MOD

软件

评论(1)